はじめに

生成AIは、テキスト、画像、コード、音声など、これまで人間の手によって作られていたコンテンツを自律的に生成する能力を持つことで、さまざまな業界に変革をもたらしています。企業が生成AIの力を活用しようとする中、クラウドプラットフォームはAIワークロードを支えるために必要な計算リソース、スケーラビリティ、インフラストラクチャを提供する重要な役割を果たします。

クラウドサービスを活用することで、組織は生成AIモデルを効率的に導入し、スケールさせることが可能となり、イノベーションを促進しデジタルトランスフォーメーションを加速させます。本セクションでは、AWS、GCP、Azure、Replicateなどの主要なクラウドプラットフォームを対象に、生成AIの実装における技術的アプローチを探り、それらの主要サービス、ベストプラクティス、そして実際の活用事例について考察します。

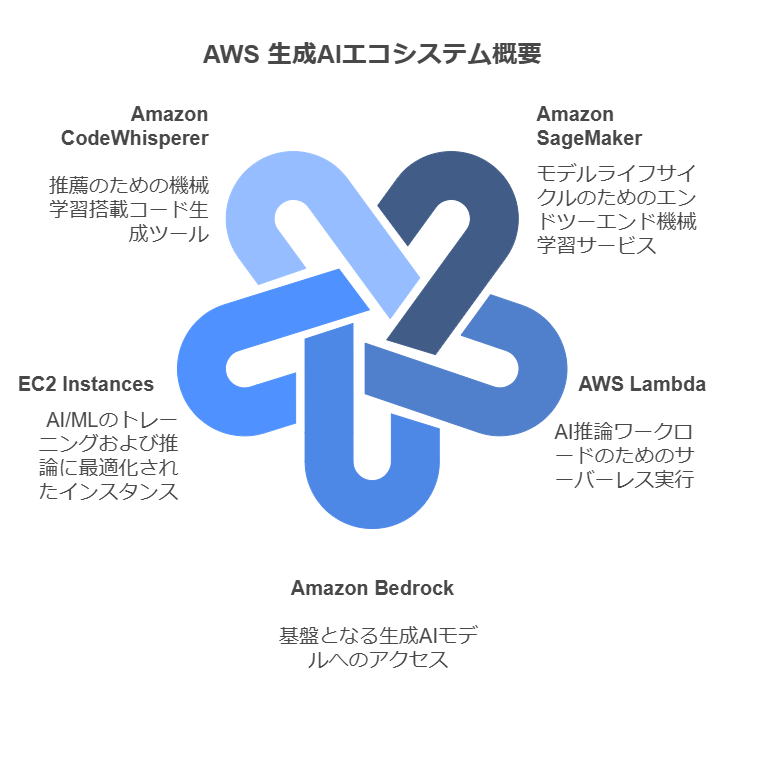

1. AWSでの生成AI

AWSは、生成AIモデルを展開およびスケールするための最も包括的なエコシステムの一つを提供しています。SageMakerやBedrockなどのサービスを利用することで、組織はモデルの構築、トレーニング、デプロイを容易に行えます。また、AWSの広大なインフラストラクチャやInferentia、Trn1インスタンスといったAI専用のハードウェアにより、複雑なAIワークロードにおける迅速な実験とコスト効率の高いスケーリングを実現できます。

主なサービス

- Amazon SageMaker: モデルの構築、トレーニング、デプロイをエンドツーエンドで支援する機械学習サービス

- AWS Lambda: AI推論ワークロードをサーバーレスで実行

- Amazon Bedrock: ClaudeやJurassic-2などの基盤生成AIモデルに直接アクセス可能

- EC2インスタンス(Inf1、Trn1): AI/MLのトレーニングや推論に最適化

- Amazon CodeWhisperer: コードの推奨を提供する機械学習搭載のコード生成ツール

アプローチ

- SageMaker JumpStart を活用して、事前学習済みモデルを利用

- SageMaker Pipelines を使用して、カスタム生成AIパイプラインをデプロイ

- AutoML 機能を活用して、ハイパーパラメータの調整を行い

- AWSのデータレイクと統合し、大規模なトレーニングを実施

事例

ある企業は、AWS Bedrockを利用して生成AI搭載のチャットボットを導入し、24時間365日自動化されたサポートを提供することで、顧客サポートを強化しています。このチャットボットは、企業のCRMや商品カタログと統合されており、複雑な問い合わせに対応したり、製品を提案したり、注文を処理したりすることができます。

一例として、Stack AI があります。Stackは、企業規模を問わず、チャットボット、ドキュメント処理、コンテンツ作成、そして自動化されたカスタマーサポートなどのAIアプリケーションを数分で構築・展開できるノーコードインターフェースを提供します。このアプリケーションは、AWSの生成AIアクセラレーターにも選ばれました。

AWSを生成AIに使用する場合の検討

利点:

- AWSサービス全体に深く統合された包括的なAI/MLエコシステム

- 専用ハードウェア(Inferentia、Trn1)によるスケーラブルでコスト効率の高い運用

- 強力なセキュリティおよびガバナンスツール

- Bedrock を通じて利用可能な幅広い事前学習済みモデル

欠点:

- 複雑な料金体系により、予期しないコストが発生する可能性があります

- AWSサービスに不慣れな新規ユーザーにとっては学習曲線が急です

- 最適なモデル調整やデプロイには相当な専門知識が必要です

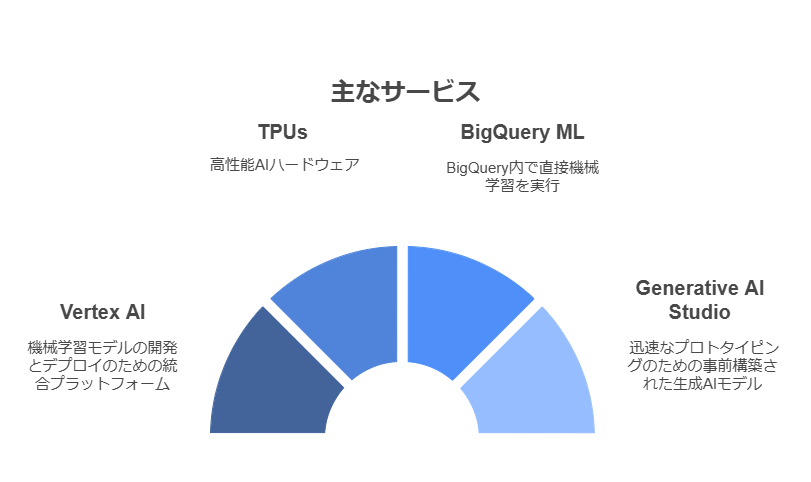

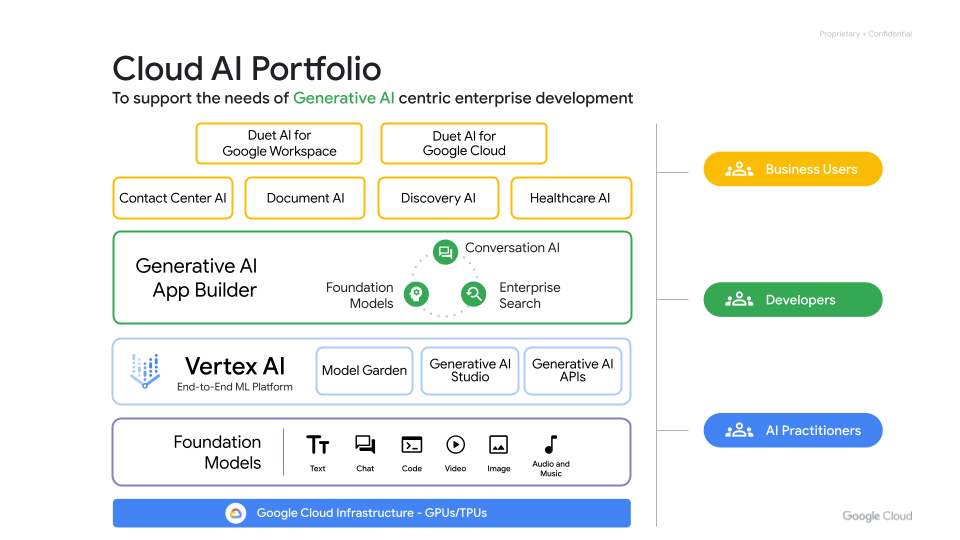

2. Google Cloud Platform (GCP)での生成AI

Google Cloud Platform (GCP)は、最先端のAIツールと強力なインフラストラクチャで知られており、生成AI分野のリーダーです。VertexAIやTPUの提供により、GCPはモデルのトレーニングおよびデプロイメントに高性能な環境を提供しています。GCPのデータ分析および機械学習パイプラインとの深い統合により、業界全体でのAI導入が加速されています。

主なサービス

- Vertex AI: 機械学習モデルの開発とデプロイのための統合プラットフォーム

- TPU(Tensor Processing Units): 高性能AIハードウェア

- BigQuery ML: BigQuery内で直接機械学習を実行

- Generative AI Studio: 迅速なプロトタイピングのための事前構築された生成AIモデル。Gemin APIへの直接アクセス

アプローチ

- Vertex AI Model Garden を活用して、最先端のモデルにアクセス

- TPU を使用してカスタムモデルをトレーニングし、パフォーマンスを向上

- Kubeflow を使用して、継続的なトレーニングパイプラインを実装

- GCPのAutoML を活用して、モデル開発を迅速化

以下は GCP生成AIエコシステムです。

事例

あるメディア企業は、Vertex AI を活用して、個々のユーザーの好みや視聴履歴に基づいたパーソナライズされたビデオ要約を生成しています。ユーザーとのインタラクションデータを分析することで、生成AIシステムは長いビデオからハイライトを自動的にまとめ、短く魅力的なクリップを作成します。

GCPを生成AIに使用する場合の検討

利点:

- パフォーマンス最適化のための業界最高水準のAIハードウェア(TPU)

- BigQuery などのデータ分析ツールとのシームレスな統合

- 事前学習済みの生成AIモデルで開発の加速

- AI研究とイノベーションに対する強力なフォーカス

欠点:

- GPUの代替に比べてTPUの使用コストが高いです

- 一部の地域ではTPUの利用可能性が限られています

- 複雑なデプロイメントプロセスにはKubernetesの専門知識が必要です

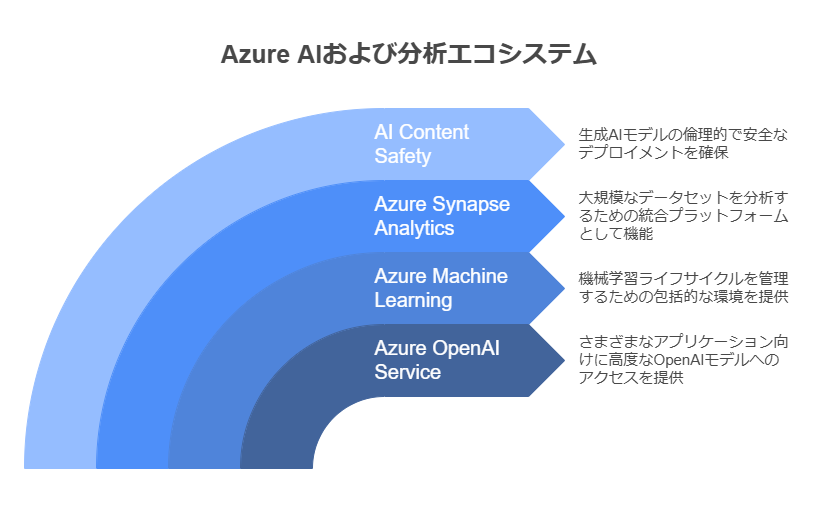

3. Microsoft Azureでの生成AI

Microsoft Azureは、OpenAIのモデルをエンタープライズ向けのサービスとシームレスに統合し、企業がスケールで生成AIを活用して革新を促進できるようにします。AzureのAIおよび機械学習ツールは、モデルの開発とデプロイを簡素化し、包括的なガバナンスと倫理的AIフレームワークにより、業界全体で責任あるAIの導入を支援します。

主なサービス

- Azure OpenAI Service: OpenAIモデル(GPT、Codex、DALL-E)への直接アクセス

- Azure Machine Learning: 機械学習ライフサイクル管理のための包括的な環境

- Azure Synapse Analytics:大規模なデータセットに対応した統合分析プラットフォーム

- AI Content Safety: 生成AIモデルの倫理的で安全なデプロイメントを確保

アプローチ

- REST APIを使用して、Azure OpenAIモデルをウェブアプリケーションに統合

- Azure MLパイプラインを使用してモデルを微調整

- Azure Kubernetes Service (AKS) を使用してスケーラブルなAIソリューションを展開

- ガバナンスのためにResponsible AIダッシュボードを実装

事例

ある金融サービス会社は、Azure OpenAI を活用して、膨大な量の財務報告書、契約書、規制文書の処理を自動化し、ドキュメントの要約を行っています。AIをデータ分析パイプラインに統合することで、手動での確認時間を50%削減し、アナリストが戦略的な洞察に集中できるようにしました。

Azureを生成AIに使用する場合の検討

利点:

- OpenAIモデル(GPT、DALL-E)との直接統合により、展開が簡素化

- ガバナンスやコンプライアンスツールを備えた企業向けの強力なフォーカス

- 機械学習ライフサイクル全体をカバーする包括的なAIスイート

- ハイブリッドおよびマルチクラウド環境に優れたサポート

欠点:

- API使用料や微調整のコストが高いです

- 地域によって特定のモデルの利用可能性が制限されています

- 新しいユーザーにはAzureのエコシステムが複雑に感じられることがありあす

4. Replicateでの生成AI

Replicateは、オープンソースの生成AIモデルを展開するための軽量で開発者向けのプラットフォームを提供します。シンプルなAPIとモデルライブラリにより、複雑なインフラを管理することなく迅速なプロトタイピングと実験が可能です。Replicateは、柔軟でコスト効率の高いAI展開ソリューションを求めるスタートアップやクリエイティブチームに最適な選択肢です。

主なサービス

- Replicate API: オープンソースAIモデルを実行するためのシンプルなAPI

- モデルライブラリ: コミュニティ提供の幅広い生成AIモデルへのアクセス

- Docker化されたデプロイメント: モデルをどこでもコンテナ化して展開

アプローチ

- 既存のモデルから選択するか、カスタムモデルをアップロード

- Replicateの分散インフラを使用して推論ワークロードをスケール

- 軽量なREST APIを使用してウェブアプリや他のクラウドサービスと統合

事例

あるデザイン代理店は、Replicate を使用して高解像度の画像やクリエイティブ資産をマーケティングキャンペーンのために生成し、クライアントのリクエストに迅速に対応しています。オープンソースモデルを微調整することで、代理店はキャンペーンの目標に合った独自のブランド固有のビジュアルを制作しています。

Replicateを生成AIに使用する場合の検討

利点:

- オープンソースモデルへのシンプルなAPIベースでのアクセス

- 小規模な展開や実験に対して低コスト

- インフラ管理なしで迅速なプロトタイピングが可能

- 柔軟な展開オプション

欠点:

- エンタープライズ規模のワークロードにはスケーラビリティが制限されています

- オープンソースモデルのみのサポート

- AWS、GCP、Azureと比較して成熟度が低いです

- ガバナンスやコンプライアンスのための組み込みツールが少ないです

5. 価格の概要

AWSの価格

- Amazon SageMaker: トレーニングジョブは、ml.t3.mediumインスタンスで1時間あたり$0.10から開始、推論コストはインスタンスタイプによって異なります。

- Amazon Bedrock: モデル推論の従量課金制、通常はリクエストごとに$0.0004から開始。

- EC2(Inf1、Trn1): Inf1インスタンスでのトレーニングは1時間あたり$1.60から開始、Trn1は1時間あたり$2.80から開始。

GCPの価格

- Vertex AI: カスタムモデルのトレーニングは、TPU v2コア1個あたり1時間$0.05から開始、モデルのデプロイは1回の予測ごとに$0.10から開始。

- TPUs: トレーニングは、TPU v4ポッドで1時間あたり$8から開始。

Azureの価格

- Azure OpenAI Service: GPTモデルは1,000トークンあたり$0.002から開始、微調整には追加費用が発生する場合があります。

- Azure Machine Learning: トレーニング用VMは1時間あたり$0.08から開始、デプロイメントは計算リソースの使用量に基づいてスケールします。

Replicateの価格

- Replicate API: 推論ごとの従量課金制、平均的なコストは使用したGPU時間の1秒あたり$0.002から開始。

- モデルデプロイメント: オープンソースモデルは、個人のハードウェアで実行する場合は無料、Replicateインフラを使用する場合、1回のモデル実行あたり$0.01から開始。

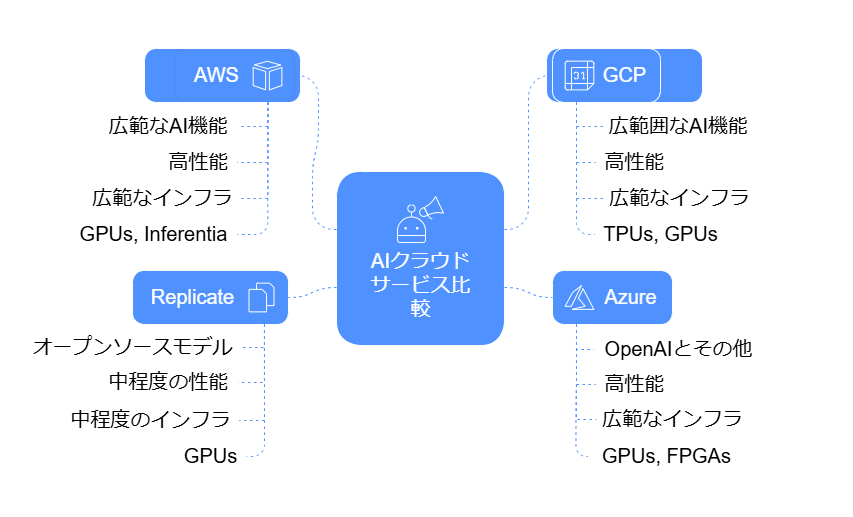

6. 比較分析

| プラットフォーム | モデルアクセス | スケーラビリティ | カスタマイズ | ハードウェアサポート |

| AWS | 広範 (Bedrock経由) | 高 | 広範囲 | GPUとInferentia |

| GCP | 広範囲 (Vertex AI) | 高 | 広範囲 | TPUsとGPUs |

| Azure | OpenAIとその他 | 高 | 広範囲 | GPUsとFPGAs |

| Replicate | オープンソースモデル | 中 | 中程度 | GPUs |

7. コアサービスの比較

| AWS Bedrock | Google Cloud Vertex AI | Azure OpenAI | Replicate |

| AWSおよびサードパーティを含む多くのプロバイダーから提供される使いやすい多数のモデル | GoogleのGeminやGemmaなどの既存のファウンデーションモデル、またはMistralやClaudeなどのサードパーティモデルの利用 | OpenAIのモデル(ChatGPT、DALL-Eなど)を使用し、サードパーティのサポートはない | 主にオープンソースモデルを実行 |

| AIを最適化するためのAWSエコシステム内のAuroraやKendraなどの多くの支援サービス | BigQueryやDataFlowなどのGCPの他のサービスへの接続サポート | Azureの他のサービス(Data Services、Power Platformなど)への接続サポート | AIモデルの展開を簡素化し、構成(GPU)のオプションを提供し、迅速にAPIに変換すること |

| カスタムモデル(微調整)のサポート | 調整済みモデル(微調整)のサポート | 微調整のサポートなし | 微調整のサポート |

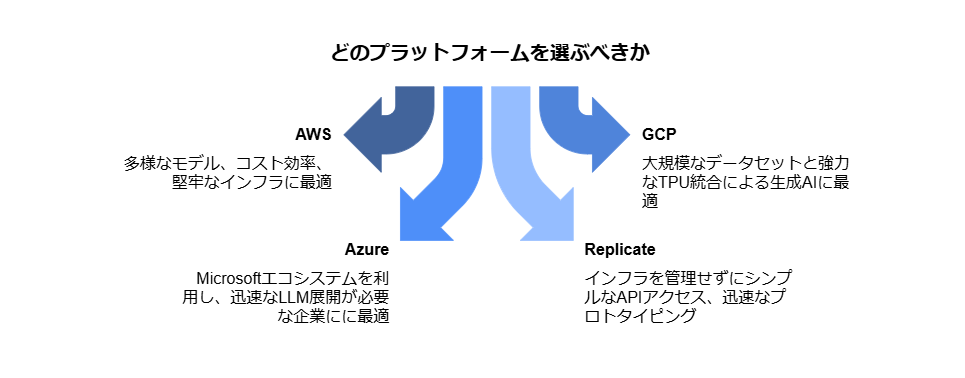

8. どのプラットフォームを選ぶべきか

・AWS: 多様なモデル、コスト効率、堅牢なインフラに最適。

・GCP: 大規模なデータセットと強力なTPU統合による生成AIに最適。

・Azure: Microsoftエコシステムを利用し、迅速なLLM展開が必要な企業にに最適。

・Replicate: インフラを管理せずにシンプルなAPIアクセス、迅速なプロトタイピング。

最後に

生成AIのためのクラウドプラットフォームの選択は、使用ケース、モデルの要件、およびスケーラビリティのニーズに依存します。AWS、GCP、Azureはエンタープライズ向けのツールとサービスを提供しており、Replicateはシンプルさとオープンソースの革新へのアクセスを提供します。組織は、適切なクラウドアプローチを使用して、生成AIの機能をワークフローに統合することで、重要な価値を生み出すことができます。